深度学习中的优化算法是求解模型参数的关键梯度下降如何通过深度学习技术实现电子设备的自适应和优化调整,作为最基础的优化手段如何通过深度学习技术实现电子设备的自适应和优化调整,通过沿负梯度方向更新参数以寻找局部最小值,但存在学习率选择和局部震荡的问题针对这些问题,SGD随机梯度下降通过随机选取部分样本加快更新速度,但其收敛性受限为了改进,如何通过深度学习技术实现电子设备的自适应和优化调整我们引入了Momentum Optimizer,通过累积之前的梯度。

不可以深度学习技术的通信研究只是智能通信技术的一个小组成部分,不足以称之为智能通信智能通信是指利用人工智能大数据等技术实现通信系统的智能化自适应和优化,从而提高网络性能减少资源浪费改善用户体验等智能通信技术需要综合运用多种技术手段,包括但不限于深度学习机器学习自然语言处理。

相较于传统的像素级适应,DANN更深入地在特征层面进行调整jinnianhui金年会,从而实现更为精确的迁移令人期待的是,后续的博客将详细解析DANN在MNIST和MNISTM迁移学习中的tensorflow实现,展示其技术细节和实战应用深度域自适应并非孤立的技术,而是深度学习领域中一项革新性的突破,它以科学的方法解决实际问题,让深度学。

33 循环神经网络在OFDM信号中的应用通过OFDM系统模型金年会客户端,LSTM神经网络处理信号时,输入门遗忘门和记忆单元协同工作,实现高效载频估计深度学习模型通过正反向传播算法训练,优化了信号处理性能第4章CNN与频谱感知的融合LeNet5的CNN模型,结合FFT载频估计算法,将频谱感知转化为图像分类任务,简化了处。

深度学习的在线学习和自适应技术,如Actor模型和SBP机制,正引领技术革新面对技术“卡脖子”的挑战,中国需自主研发深度学习框架,如华为的Mindspore,实现差异化竞争然而,中国框架的发展需注重创新,既要借鉴国际先进经验,又要发掘本土优势,以实现深度学习技术的多元化发展总的来说,深度学习正在以。

深度学习的优点在于其具有强大的自学习能力和泛化能力与传统机器学习相比,深度学习可以从大量的数据中提取更多的特征信息,并用于更准确的预测和分类此外,深度学习模型可以自适应地调整参数,因此在应对新的数据时具有更好的适应性随着深度学习技术的不断发展,它已经成为了计算机科学领域的热门话题。

2 深度学习深度学习是机器学习的延伸,它利用神经网络模型来模拟人脑的工作原理,通过大量的神经元之间的交互和训练,实现对复杂数据的自适应学习能力3 自然语言处理自然语言处理技术可以让计算机理解和生成人类语言,从而实现人机交互4 计算机视觉计算机视觉技术可以让计算机识别和理解图像和视频。

如何通过深度学习技术实现电子设备的自适应和优化调整你手动设置规则比如前一千次01然后001这叫手动设置,比较常见的SGD 还有一些optimizer是根据计算的梯度计算的,比如Adam,也就是lr是实时变化的最好去别的方式是,如果你在运行前就知道每一步的lr,那就叫手动,反之则是自适应。

探索SENet深度学习中的智能注意力机制 在深度学习的璀璨星河中,SENet犹如一颗璀璨的明珠,由Jie Hu及其团队在2017年精心打造它旨在革新卷积神经网络CNN的内在运作,通过引入自适应特征提取的注意力机制,提升通道间信息传递的效率,赋予模型更强的表达力SE模块的核心在于其独特的quotSqueezequot和quot。

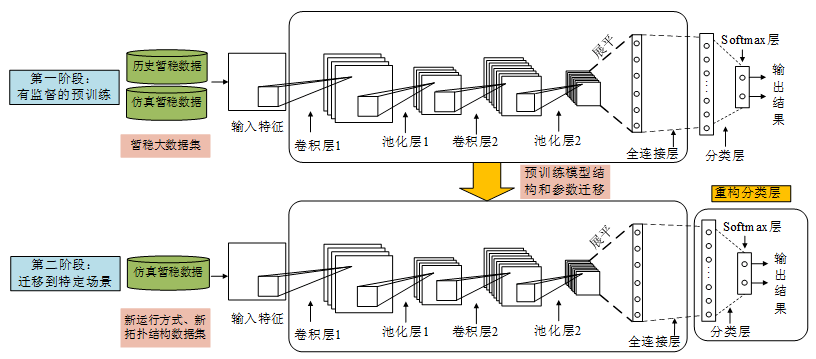

方法包括重新加权源数据以减小分布差异如AR方法,以及迭代地对目标领域数据进行标记如协同训练领域不变特征学习是关键,通过创建在源和目标领域都适用的特征表示,如层次贝叶斯模型和基于对抗的自适应此外,还有像素级和特征级的域映射技术,如StarGAN,它学习多领域之间的映射关系,以实现无缝转换。

4 自适应学习人脑能够根据环境变化自我调整视觉处理策略深度学习算法通过不断优化网络参数,根据输入数据自适应学习并提高性能5 并行处理人脑的视觉处理是高度并行的深度学习利用并行计算技术,如GPU加速,来提高模型训练和推理的速度此外,人脑视觉机理的其如何通过深度学习技术实现电子设备的自适应和优化调整他特点,如层次化的特征提取并行计算。

吴恩达的机器学习课程,斯坦福强化学习和MIT的深度学习课程,为学习者提供了丰富的学习资源不断优化学习策略,如Label Smoothing Regularization,也是提升模型性能的关键步骤总的来说,注意力机制是深度学习中一颗璀璨的明珠,它在各种场景中发挥着至关重要的作用,不断推动着人工智能技术的革新与进步。

运动学优化通过优化机械臂的运动学参数,如关节角度和速度,提高机械臂的稳定性和灵活性 动力学优化通过优化动力学参数,如力矩和加速度,使机械臂在面对不同生产环境时能够做出更准确的判断和决策 自适应控制采用自适应控制技术,使机械臂能够根据不同环境自动调整运动学和动力学参数。

FastBERT,北京大学和腾讯的联合研究,引入Selfdistillation和样本级自适应机制,允许根据任务需求动态调整推理时间预训练与Finetuning相结合,自适应学习策略使得在分类任务中展现出了强大的威力这些方法的背后,是深度学习模型压缩与加速领域的持续探索与突破,参考文献125记录了这一领域的累累硕果。

基础的梯度下降法是基石,动量技术则提升了收敛速度,而AdaGrad则巧妙地通过动态调整学习率,提升了梯度下降的稳定性和效率在深度优化算法的行列中,RMSProp和AdaDelta改进了AdaGrad,通过梯度平方累积和衰减机制,解决了学习率过早消失的问题Adam算法则融合了自适应学习率和动量,通过梯度向量m和v的更新。

而人工神经网络作为深度学习的基础,其重要性不言而喻未来,随着技术的不断进步,人工神经网络将更加智能化个性化,为人类提供更好的服务总之,人工神经网络是一种模拟人类神经系统结构和功能的计算模型,具有良好的自适应和学习能力,在多个领域都有广泛的应用。

为了适应各类设备的能耗需求,算法还采用了能耗优化策略,如结构化剪裁资源自适应和量化技术,最终打造出轻量级的500KB模型,适用于广泛场景接下来,我们将深入探讨这些策略如何实现模型的高效与资源的灵活运用轻量化与资源自适应 轻量化技术 通过量化剪枝和模块化等手段,阿里云Denoise在保证性能的。